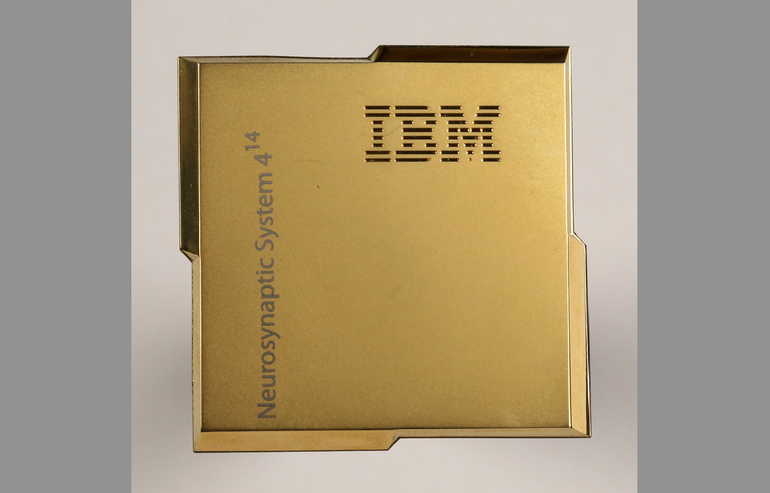

Az IBM bemutatott egy agyként működő chipet, mely 4,000 processzor magot tartalmaz

Az emberi agy a világ legnagyobb teljesítményű számítógépe, mely képes fejlődni, beszédet felismerni és reagálni az ismeretlenre. A digitális technológia hajnala óta a tudósok igyekeznek olyan eszközt létrehozni, mely hasonlóan működik.

Az eddigi kísérletek zömében program szintjén próbálták utánozni az agy működését, de az utóbbi években néhány tudós figyelme abba az irányba terelődött, hogy egy idegrendszer által ihletett chipet fejlesszenek ki, mely az információt alapvetően másképp dolgozza fel. Ez vezetett ahhoz a projekthez, melynek gyümölcse egy kutatási tanulmány lett, melyet a „Science” nevű akadémiai lapban tettek közzé. Itt hozták nyilvánosságra, hogy kifejlesztették a TrueNorth nevű agyhoz hasonló chipet, melyet egy egyszerűbb, még 2011-ben elkezdett kísérletre alapoztak.

A TrueNorth 4,096 magjával 1 millió emberi idegsejt és 256 millió szinapszis működését tudja utánozni. Az IBM ezeket „tüske idegnek” hívja. Céljuk, hogy az adatot impulzus mintákba kódolják, ami egy neurológusok által hitt a sok mód közül, ahogyan az agy tárolja az információt.

„Ez tényleg egy jó kis kísérlet áramkör architektúrában” mondja Carver Mead a Californiai Technológiai Intézmény mérnök szakos professzora, akit az „idegrendszer” alapú hardverek nagyapjának tekintenek. „Ez egy jó első lépés.” A hagyományos processzorok – mint a CPU, mely a számítógép fő feladatait intézi, vagy a GPU, ami a grafikus megjelenítéshez szükséges matematikai számolásokat kezeli – nem képesek olyan módon kódolni az adatot, mint ahogyan azt az emberi agy teszi. „Az információt ideg-impulzusokba kódolni… ez nem volt lehetséges az eddigi digitális technológiával.” – mondja Carver Mead.

Az IBM már tesztelte, hogyan kezeli a chip a közönséges mesterséges intelligencia feladatokat, mint például a képek felismerése. A kísérlet eredménye, hogy jóval kevesebb erőforrás és energia felhasználásával tudja az új rendszer ezt megtenni, mint a hagyományos chipek. Mikor azt tesztelték, hogy a TrueNorth hogyan teljesít egy videó felismerő rendszerben, sikeresen felismert embereket, autókat, buszokat és bicikliseket kb. 80%-os pontossággal; mi több, a kísérletek azt igazolják, hogy kevesebb energiát fogyaszt a feladatok elvégzése során, mint a hagyományos chipek.

Dharmendra Modha, a projekt felügyelője szerint „nincs olyan CPU, nincs olyan GPU, se hibrid számítógép, mely akár megközelítené ezt a technológiát.” „A chip valós idejű teljesítményre lett kifejlesztve, senki nem képes ehhez hasonló valós idejű teljesítményt nyújtani.” A trükk, hogy cserépszerűen össze lehet kötni a chipeket és így egy óriási idegrendszert alkothatunk. Az IBM 16 chipből álló sémát alkotott néhány hete, mely képes volt valós időben videót feldolgozni.

Maga a séma és a chipek is csak prototípusok, de az IMB úgy hiszi, ez a technológia megújítja a jelenleg ismert számítástechnikát. „Ez egy modern gép egy modern kornak” mondja Modha. „Mi tényleg azt hisszük, hogy ez új mérföldkő az emberi agy ihlette számítástechnikának.” De a kérdés továbbra is fennáll, mire képes még ez a technológia és ténylegesen mennyire különbözik az eddig ismert eljárásoktól.

Az IBM új chipje része a SyNAPSE projektnek, melynek fő célja az emberi agy működéséhez minél jobban hasonlító hardver kifejlesztése. A 2008-ban indult projektbe, mely ezt a chipet is fejlesztette, 53 millió dollárt fektettek. Az IMB célja megváltoztatni a Neumann által lefektetett számítástechnika alapját. A Neumann-féle számítógépben az adattárolás és -feldolgozás szét van választva a memória és a processzor között. Minden folyamatnál a Neumann számítógépnek az adatot a memória és a processzor között kell oda-vissza mozgatnia és ez sok energiát vesz igénybe. A többmagos chipek, illetve a cache-ben való adattárolás is azt a célt szolgálja, hogy ezt a folyamatos adatmozgatást segítse, viszont ez csak időt nyer, nem energiát. Ez azt is jelenti, hogy a számítógépek sosem dolgoznak tényleges valós időben.

Az IBM által kifejlesztett chip nem választja szét az adat tárolását és feldolgozását, hanem kis modulokban tárolja az adatokat, melyek a helyszínen kerülnek feldolgozásra, de egymással is tudnak kommunikálni és ez teszi lehetővé a valós idejű működést és energia megtakarítást, ez a tulajdonság teszi a chipet keresetté.

Sokan viszont megkérdőjelezik mennyire is újdonság ez. „Jó pont, hogy a memória és a processzor közel van egymáshoz. De miként lehet majd a mai informatikai igényekhez idomítani? Mert ha egy méretes adatbázist kell kezelnie, akkor itt is szét kell majd választani az adattároló és -feldolgozó egységet.” mondja Eugenio Culurciello a Purdue Egyetem professzora.

Mások szerint ahhoz, hogy elváljunk az eddig ismert számítástechnikai alapoktól, szükséges, hogy az „ideg” és „agy” mintájú technológia tudjon tanulni és fejlődni, nem csak hozzá illesztett adatbázis segítségével bővülni. „Előrelépés, hogy ehhez hasonló chipet sikerült kifejleszteni, de ez magában nem rengeti meg az alapokat, mert nem történik tanulás magán a chipen.” mondja Nayaran Srinivasa a HRL egyik tudósa, aki hasonló technológián dolgozik. „Az adat feldolgozása és használata tényleg a TrueNorth-on történik, de az információ még mindig hagyományos úton kerül a rendszer birtokába.” Az IBM viszont nem veti el a chip-en való tanulás lehetőségét a jövőre nézve.

Kritikusok szerint a technológiának még sok kísérleten kell bizonyítania, mielőtt a mai adatközpontokban használható lenne, intelligensebb telefonok vagy kamerák készítéséhez vezetne. “Tévedés lenne azt hinni, hogy nemsokára agyszerű chipek lesznek a kezünkben.” Vélekedik LeCun, akinek a laboratóriuma több éve foglalkozik idegrendszerszerű hardverrel. „Én teljes szívvel támogatom, hogy olyan chipeket építsünk, melyek ideghálókat irányítanak. De szerintem célszerű olyan chipeket építeni, melyek algoritmusokat tartalmaznak, és amelyek segítik a már meglévő technológiánk működését.” „Ez az ágazat még sokáig nem fog kiforrni, ha valaha is ki fog egyáltalán. Lehetséges, hogy nemsokára lesznek olyan chipek, melyeket mobiltelefonokban fel lehet használni, de ezek nem úgy néznek majd ki, mint az IBM chipje, hanem inkább módosított GPU-k lesznek.”